Karty graficzne RTX 3060 trafią do sprzedaży oficjalnie 25 lutego. Klienci rzucili się do sklepów, mimo że Nvidia nie udostępniła nawet oficjalnej specyfikacji technicznej. Firma robi to jednak teraz. Co konkretnie oferują nadchodzące karty? Poniżej znajduje się specyfikacja RTX 3060.

Ciągle nie znamy szczegółów na temat zastosowanego procesora GPU GA106 – nie wiemy, na jakim konkretnie modelu opiera się RTX 3060. Brakuje też kilku podstawowych informacji, takich jak liczba rdzeni Tensor czy RT. Najwidoczniej Nvidia wychodzi z założenia, że klienci nieszczególnie interesują się takimi danymi. A przynajmniej większość z nich.

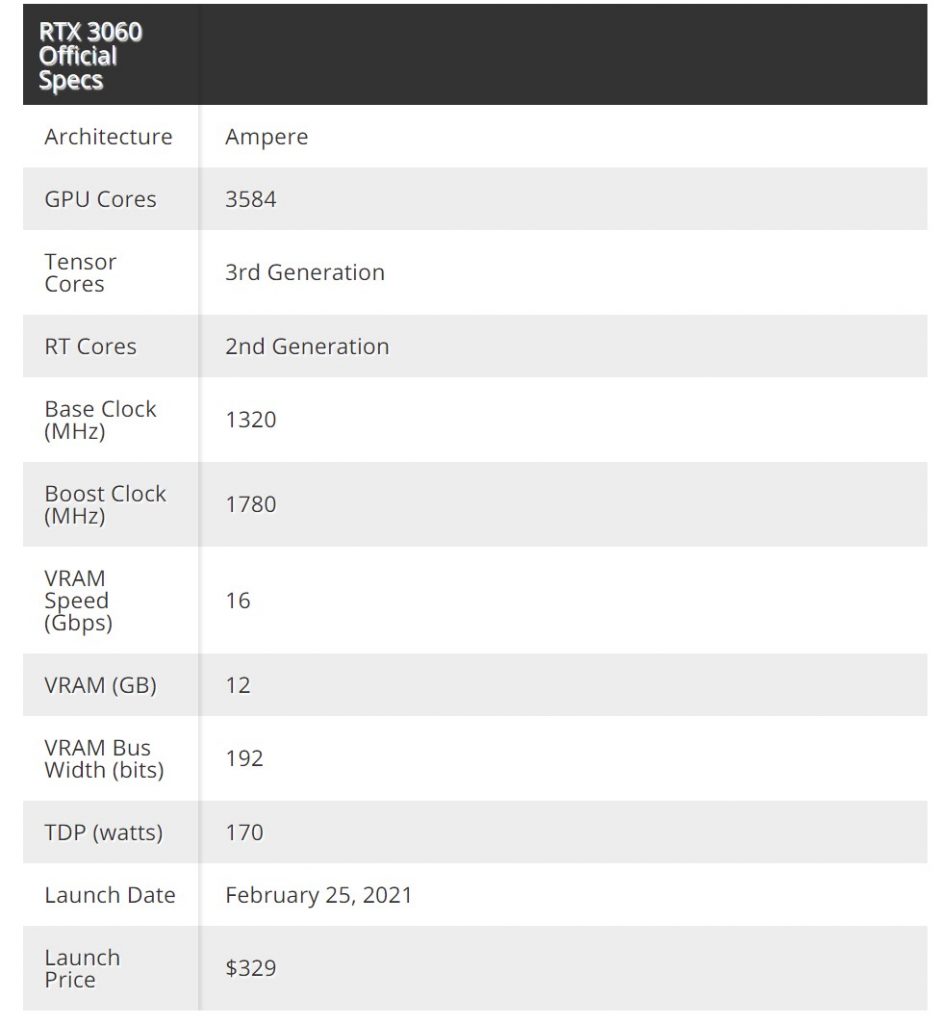

Specyfikacja RTX 3060 – to będzie udana grafika

Prezentujemy tabelę z danymi:

Zagraniczne źródło twierdzi, że najnowsze karty graficzne Nvidii zaoferują wydajność na poziomie 13 Shader TFLOPS, 25 RT TFLOPS i 101 Tensor TFLOPS. To oznaczałoby, że karty zapewnią 3584 rdzeni GPU, co przełoży się na 28 rdzeni SM, 28 rdzeni RT, a także 112 rdzeni Tensor w RTX 3060. Ostatecznie będziemy mogli to potwierdzić dopiero wtedy, gdy karty zostaną przetestowane przez niezależne media.

Nvidia ma jeszcze trochę czasu, aby ujawnić więcej szczegółów o RTX 3060. Oficjalna premiera sklepowa rusza 25 lutego. Już teraz jednak sklepy wystawiają karty w przedsprzedaży – często dwukrotnie w dwukrotnie wyższej cenie, niż zaleca producent. Oficjalnie jednak karta powinna kosztować nieco ponad 300 dol. W sklepach pojawia się jednak nawet za ponad 600 dol. W Polsce nowy RTX na razie nie jest dostępny, nawet w przedsprzedaży.

Przypomnijmy też, że Nvidia wprowadzi do sprzedaży również starsze karty graficzne, aby klienci mogli kupić też inne sprzęty, gdy RTX-ów zabraknie. Ostatnio firma zapewniła też dostęp do technologii Nvidia DLSS dla wielu nowych gier.

Czy odpowiada wam taka specyfikacja RTX 3060? Dajcie znać w komentarzach.

Zobacz też:

Google, Microsoft i Qualcomm nie chcą, aby Nvidia przejęła Arm

Nvidia do producentów laptopów z RTX 3000: nie wprowadzajcie w błąd!

Nvidia precyzuje wymagania G-Sync Ultimate

Źródło: Tom’s Hardware.com