Zastanawiacie się co to jest HDR? A może jak włączyć HDR? Spokojnie – w tym artykule tłumaczymy wszystko co musicie wiedzieć.

Spis treści

Co to jest HDR?

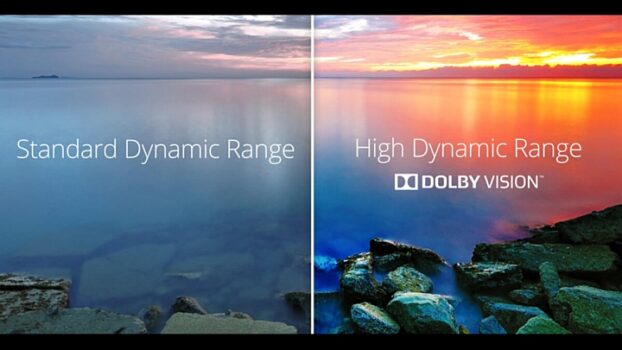

HDR, czyli High Dynamic Range, to technologia obrazowania szeroko stosowana w dzisiejszych telewizorach, monitorach, aparatach fotograficznych i urządzeniach mobilnych. Pozwala ona na uzyskanie większej różnicy między najciemniejszymi a najjaśniejszymi obszarami obrazu, co skutkuje bardziej realistycznymi i dynamicznymi wrażeniami wizualnymi dla użytkowników.

Podstawową ideą HDR jest zwiększenie zakresu jasności i kontrastu w porównaniu z tradycyjnymi technologiami obrazowania, takimi jak standardowy zakres dynamiczny (SDR). Dzięki temu możliwe jest oddanie bogatszych kolorów, głębszych czerni i jaśniejszych odcieni białego, co prowadzi do bardziej realistycznego obrazu.

W przypadku treści wideo, zastosowanie HDR umożliwia bardziej realistyczne odwzorowanie kolorów i szczegółów, szczególnie w przypadku scen o dużym kontraście, takich jak wschody słońca, zachody słońca czy efekty świetlne. Dzięki HDR oglądane filmy czy programy nabierają życia i głębi, co zwiększa wrażenia widzów.

Jakie są standardy HDR?

Dolby Vision

Oczywiście, istnieje kilka standardów HDR – nie jest to jedna, sztywno określona technologia. Producenci bardzo chętnie ścigają się zatem w tym, kto wymyśli lepszy i bardziej nowoczesny standard. Kilka z nich zdecydowanie cieszy się jednak największą popularnością.

Jednym z najpopularniejszych standardów jest HDR10. Jest to otwarty standard, który oferuje szeroki zakres kolorów i głębię kontrastu. HDR10 jest wspierany przez większość telewizorów i urządzeń multimedialnych, co sprawia, że jest szeroko stosowany w przemyśle rozrywkowym. Równie ważny jest jego bezpośredni następca, czyli HDR10+ – nowsza wersja z dynamicznymi metadanymi. Co istotne – to darmowa licencja!

Dolby Vision to kolejny znaczący standard HDR, rozwijany przez Dolby Laboratories. Jest to format oparty na metadanych dynamicznych, co oznacza, że obraz jest dostosowywany w czasie rzeczywistym do możliwości danego ekranu. Działa podobnie co HDR10+, ale jest już objęty licencją komercyjną.

Hybrid Log-Gamma (HLG) to z kolei standard opracowany przez BBC i NHK. Jest to hybrydowy format, który można odtwarzać zarówno na urządzeniach HDR, jak i na tradycyjnych ekranach SDR. HLG jest często stosowany w transmisjach telewizyjnych oraz w produkcji treści wideo, co czyni go istotnym standardem w przemyśle telewizyjnym.

Ponadto istnieją także inne standardy HDR, takie jak Technicolor HDR czy Advanced HDR by Technicolor, które są stosowane w niektórych produktach i treściach wideo. Nie stanowią jednak bardzo istotnej części całego rynku.

Jakie urządzenia są kompatybilne z HDR?

Oczywiście, aby móc cieszyć się obrazem HDR konieczny jest wyświetlacz (monitor lub telewizor) kompatybilny z tym standardem. Inaczej nie jest to absolutnie wykonalne. Najczęściej producenci sami nas o tym bardzo wyraźnie informują i reklamują tak swoje produkty. W końcu to spory atut. Możemy sprawdzić to jednak samodzielnie!

Po pierwsze, urządzenie musi mieć zakres jasności na poziomie co najmniej 1000 cd/m². Im wyższa wartość, tym lepiej, ponieważ pozwala to na uzyskanie większej różnicy między najciemniejszymi a najjaśniejszymi obszarami obrazu, co skutkuje bardziej realistycznymi wrażeniami wizualnymi.

Kolejnym istotnym czynnikiem jest wysoki czynnik kontrastu. Im wyższy kontrast, tym lepsze efekty podczas oglądania treści w HDR. W końcu o to chodzi w tym standardzie. Dodatkowo, panele urządzenia muszą być co najmniej 10-bitowe, aby zapewnić prawdziwą głębię koloru i intensywne barwy, a także ostre detale.

Rozdzielczość 4K Ultra HD (3840 × 2160 pikseli) jest kolejnym ważnym kryterium. Dzięki niej możliwe jest cieszenie się jeszcze wyraźniejszymi szczegółami na ekranie, co podnosi jakość oglądanych treści. Ważne jest także posiadanie złącza HDMI co najmniej w wersji 2.0. To właśnie dzięki temu złączu można podłączyć zewnętrzne źródło danych, takie jak odtwarzacz Blu-ray czy konsola do gier i cieszyć się filmami w lepszej jakości.

Jak włączyć HDR w grach?

W przypadku telewizorów, obsługa HDR odbywa się zwykle automatycznie. Podczas grania na komputerze musimy ją jednak czasami włączyć, a wręcz wymusić, jeśli dana gra nie była projektowana domyślnie pod nią.

Aby włączyć HDR w systemie Windows, przechodzimy do ustawień, klikamy przycisk “Start” i wybieramy “Ustawienia”. Następnie przechodzimy do sekcji “System” i znajdujemy opcję “Ekran”. W tej sekcji znajdujemy ustawienia związane z HDR i jasnością. Tutaj możemy włączyć tę opcję i dostosować ustawienia, jeśli to konieczne. Po dokonaniu zmian upewniamy się, że kliknęliśmy przycisk “Zastosuj” lub “OK”, aby zapisać ustawienia. Teraz nasz system Windows jest gotowy do wyświetlania treści zgodnych z tym standardem na odpowiednio wyposażonym monitorze.

No właśnie – standard możemy wymusić na grze, która nie była pod to projektowana. Absolutnie nie zrobimy tego jednak na wyświetlaczu, który nie był zgody z tym standardem. Oprogramowanie można oszukać – czysto fizycznego sprzętu już nie.

Zobacz też:

Jak zamontować telewizor na ścianie? Poradnik krok po kroku

Jaki monitor gamingowy? Ranking najlepszych modeli